「The 2025 AI Index Report」의 "Responsible AI" 챕터에서는 '책임 있는 AI'(Responsible AI, 이하 RAI)'의 다양한 측면에서 나타나는 트렌드를 살펴봅니다.

먼저 핵심적인 RAI 개념 정의로 시작하여, AI 사고 사례, 대형 언어 모델(LLM) 책임성의 표준화 과제, 모델의 사실성 및 진실성을 평가하는 벤치마크 등 광범위한 이슈들을 평가합니다.

이후 산업계, 학계, 정책 영역 등 주요 사회 부문에서 나타나는 RAI 동향을 살펴보고, 프라이버시와 데이터 거버넌스, 공정성, 투명성 및 설명 가능성, 보안과 안전성과 같은 세부 주제를 중심으로, 모델 성능을 드러내는 벤치마크와 주목할 만한 연구 사례를 분석합니다.

목차

- RAI를 위한 새로운 벤치마크들

- 빠르게 늘어나는 AI 관련 사고

- RAI 주요 리스크와 미흡한 대응

- 정치인들과 AI

- 공개 데이터 수집 제한

- 파운데이션 모델 연구의 투명성

- 사실과 진실을 평가하는 벤치마크

- AI 관련 선거 허위정보

- AI 모델의 암묵적 편항 문제

- RAI에 대한 학계의 관심

이 포스팅은 Standford HAI가 2025년 4월에 발행한 「The 2025 AI Index Report」의 일부 내용을 요약하고 의역한 글입니다.

보고서의 정확한 내용이 궁금하신 분들은 원문(영어)을 참고해 주세요.

1. RAI를 위한 새로운 벤치마크들

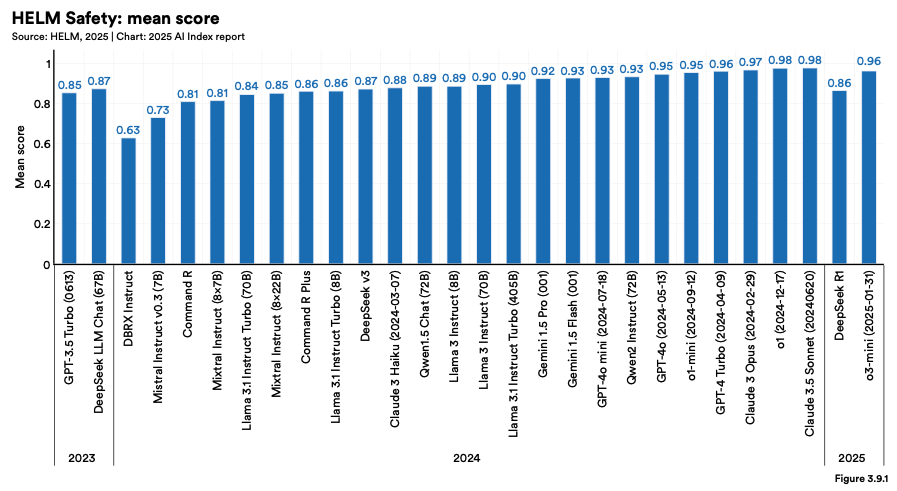

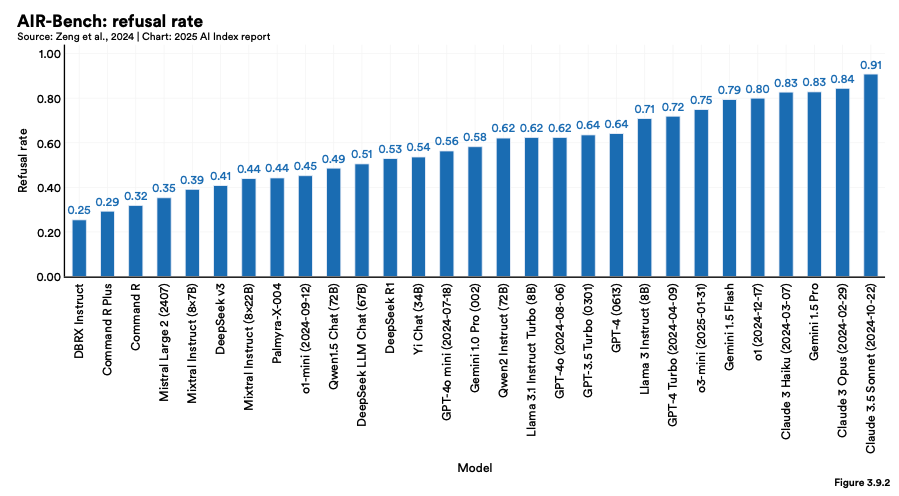

AI 시스템을 RAI 기준으로 평가하는 일은 아직 일반적이지 않지만, 새로운 벤치마크들이 점차 등장하고 있습니다.

작년 보고서에서는 LLM에 대해 표준화된 RAI 벤치마크가 부족하다는 점을 강조했습니다. 이 문제는 여전히 남아 있지만, HELM Safety와 AIR-Bench와 같은 새로운 벤치마크들이 그 공백을 메우는 데 기여하고 있습니다.

2. 빠르게 늘어나는 AI 관련 사고

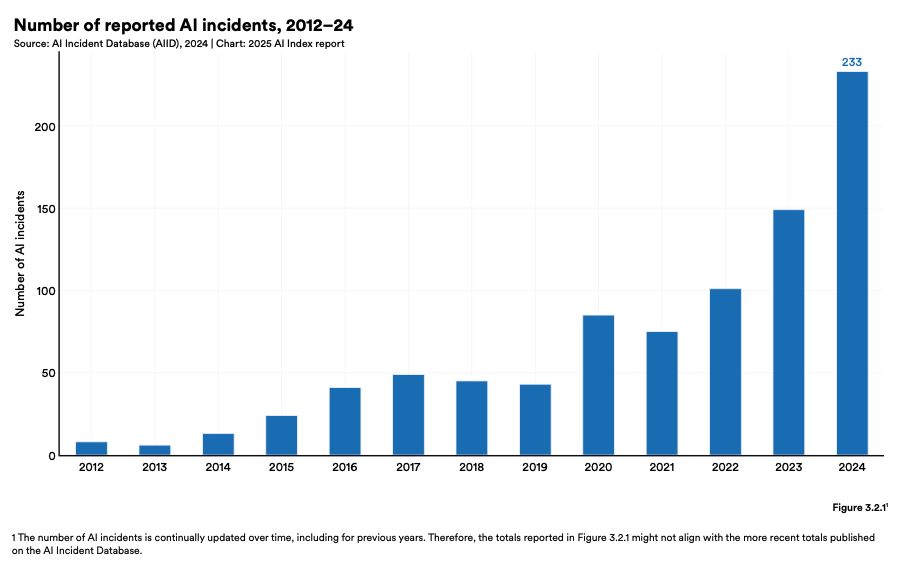

AI 관련 사고 보고 건수는 계속 증가하고 있습니다.

AI 인시던트 데이터베이스(AI Incidents Database)에 따르면, 2024년 보고된 AI 관련 사고는 233건으로 사상 최고치를 기록했으며, 이는 2023년에 비해 56.4% 증가한 수치입니다.

3. RAI 주요 리스크와 미흡한 대응

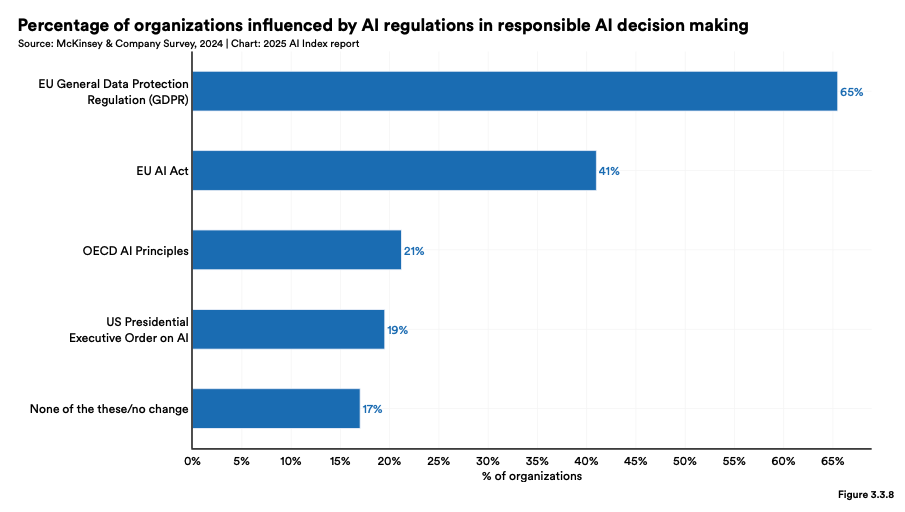

많은 조직이 RAI 리스크를 인식하고 있으나, 실제 대응은 미흡한 실정입니다.

맥킨지(McKinsey)의 RAI 참여 관련 설문조사에 따르면, 다수의 조직이 RAI와 관련된 주요 리스크(부정확성, 규제 준수, 사이버보안 등)를 인지하고 있음에도 불구하고, 이에 대해 적극적인 조치를 취하고 있는 경우는 많지 않았습니다.

각각의 리스크를 중요하게 여긴다고 응답한 비율은 64%, 63%, 60%에 그쳤습니다.

4. 정치인들과 AI

전 세계적으로 정책 입안자들은 RAI에 대해 높은 관심을 보이고 있습니다.

2024년에는 책임 있는 AI 거버넌스에 대한 글로벌 협력이 강화되었으며, 이는 신뢰성, 투명성, 설명 가능성과 같은 RAI 핵심 원칙들을 명문화하려는 데 초점이 맞춰졌습니다.

OECD, 유럽연합(EU), 유엔(UN), 아프리카연합(AU) 등 주요 국제기구들은 이러한 주요 원칙을 담은 프레임워크를 발표했습니다.

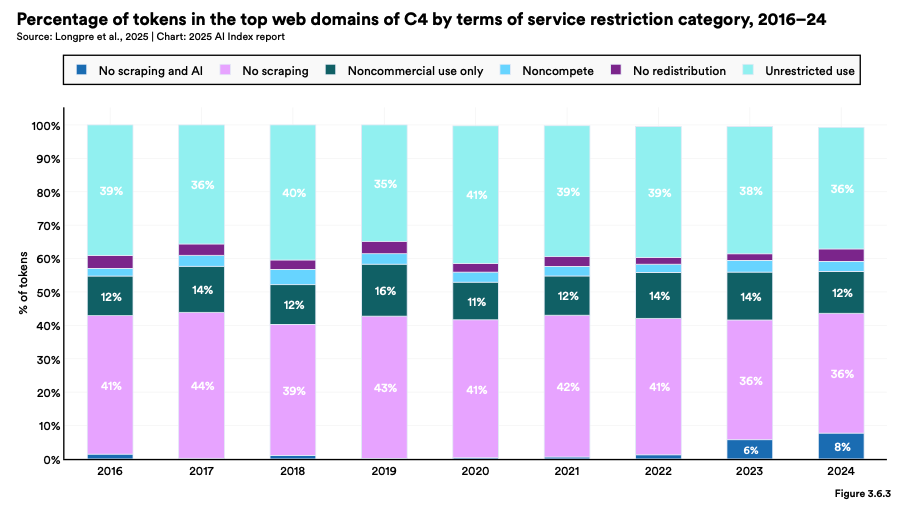

5. 공개 데이터 수집 제한

공개 데이터 자원의 축소가 빠르게 진행되고 있습니다. AI 모델은 훈련을 위해 방대한 양의 공개 웹 데이터를 필요로 합니다.

그러나 최근 연구에 따르면, 2023년부터 2024년 사이에 데이터 사용에 대한 제한이 크게 증가했습니다. 많은 웹사이트들이 AI 학습을 위한 데이터 스크래핑을 방지하기 위해 새로운 접근 제한 프로토콜을 도입했기 때문입니다.

실제로 C4 공용 크롤링 데이터셋에서 적극적으로 관리되는 도메인 내에서는 제한된 토큰의 비율이 57%에서 20~33%로 급등했습니다.

이러한 변화는 데이터 다양성, 모델 정합성, 확장 가능성에 영향을 미치며, 향후 제약된 데이터 환경에서의 학습 방식에 새로운 접근이 필요할 수 있음을 시사합니다.

6. 파운데이션 모델 연구의 투명성

파운데이션 모델(Foundation model, 광범위한 데이터를 사용해 학습된 대규모 인공지능 모델) 연구의 투명성은 향상되고 있지만, 여전히 개선의 여지가 많습니다.

파운데이션 모델 생태계의 투명성을 추적하는 프로젝트인 파운데이션 모델 투명성 지수(FMTI)에 따르면, 주요 모델 개발자들의 평균 투명성 점수는 2023년 10월 37%에서 2024년 5월 58%로 상승했습니다.

이러한 개선은 고무적이지만, 여전히 상당한 개선이 요구되는 상황입니다.

7. 사실과 진실을 평가하는 벤치마크

사실성과 진실성 평가를 위한 벤치마크도 진화하고 있습니다.

AI 모델의 사실성과 진실성을 평가하기 위해 도입된 기존 벤치마크(HaluEval, TruthfulQA 등)는 AI 커뮤니티 내에서 널리 채택되지 못했습니다.

이에 따라, 보다 포괄적이고 정교한 새로운 평가 방법들이 등장하고 있으며, 대표적으로 업데이트된 Hughes Hallucination Evaluation Model 리더보드, FACTS, SimpleQA 등이 있습니다.

8. AI 관련 선거 허위정보

AI 관련 선거 허위정보는 전 세계적으로 확산되고 있지만, 그 영향력은 여전히 불분명합니다.

2024년에는 미국 대선을 포함하여 10개 이상의 소셜미디어 플랫폼과 10여 개국 이상에서 AI가 생성한 선거 허위정보 사례가 다수 보고되었습니다.

그러나 이러한 허위정보가 선거에 실질적으로 얼마나 영향을 미쳤는지에 대해서는 여전히 논란이 있으며, 많은 사람들은 그 영향이 실제보다 더 클 것이라 예상했지만 아직 명확한 증거는 부족합니다.

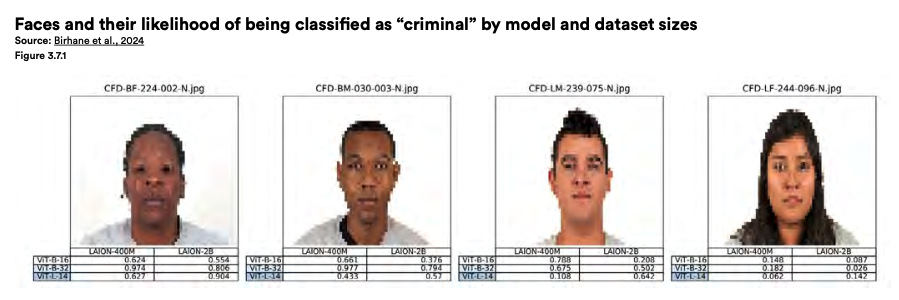

9. AI 모델의 암묵적 편항 문제

편향 방지를 목표로 훈련된 LLM도 여전히 암묵적 편향을 드러내고 있습니다.

GPT-4와 Claude 3 Sonnet 등 여러 고급 LLM은 명시적 편향을 억제하기 위한 조치를 반영하여 설계되었으나, 여전히 암묵적인 편향을 보이고 있습니다.

이들 모델은 흑인에 대해 부정적인 용어를 과도하게 연결하거나, 여성은 STEM(과학, 기술, 공학, 수학)보다 인문학 분야에 더 자주 연결하며, 남성을 리더십 역할과 더 강하게 연관 짓는 경향을 보이고 있습니다.

이로 인해 AI 의사결정에서 인종 및 성별 편향이 강화될 수 있습니다. 표준 벤치마크 기준에서의 편향 지표는 개선되었지만, AI 모델의 편향 문제는 여전히 과제로 남아 있습니다.

10. RAI에 대한 학계의 관심

RAI에 대한 학계의 관심이 높아지고 있습니다.

주요 AI 학회에서 채택된 RAI 관련 논문 수는 2023년 992편에서 2024년 1,278편으로 28.8% 증가했으며, 2019년 이후 매년 꾸준히 증가 추세를 보이고 있습니다.

이러한 성장세는 AI 연구 커뮤니티 내에서 RAI의 중요성이 점점 더 부각되고 있음을 보여줍니다.

'인공지능 > AI 인사이트' 카테고리의 다른 글

| [Stanford HAI] "교육 분야" 핵심 요약 (The 2025 AI Index Report) (1) | 2025.08.03 |

|---|---|

| [Stanford HAI] "AI 정책 분야" 핵심 요약 (The 2025 AI Index Report) (3) | 2025.08.03 |

| [Stanford HAI] "과학 및 의학 분야" 핵심 요약 (The 2025 AI Index Report) (1) | 2025.08.03 |

| [Stanford HAI] "경제 분야" 핵심 요약 (The 2025 AI Index Report) (2) | 2025.08.03 |

| [Stanford HAI] "기술 성과 분야" 핵심 요약 (The 2025 AI Index Report) (0) | 2025.08.03 |

| [Stanford HAI] "연구 개발 분야" 핵심 요약 (The 2025 AI Index Report) (0) | 2025.08.02 |

| [McKinsey / Bain / BCG] 3대 컨설팅사 주요 AI 인사이트 번역 & 정리 (25.04~25.05) (0) | 2025.05.31 |

| [Bain] 전통적인 마케팅 퍼널의 위기: 제로 클릭 퍼널과 AI 에이전트 (25.04) (0) | 2025.05.31 |